La question de la valeur des signes avec l'avènement d'Internet

Notons immédiatement que la matière qui est mise en partage entre les Internautes est "du signe" : images, vidéos, symboles, textes. Ces signes autorisent une plasticité remarquable. Au contraire des objets matériels, il est possible de les agencer sans contrainte : changement de contexte, collage, juxtaposition, regroupement, réfraction, diffraction, etc.. Cette multiplicité d'arrangements permet de constituer progressivement une "valeur d'usage" qui cristallise les liens construits entre les internautes

En organisant les signes de façon à constituer et à stabiliser des "cibles", Google ou Facebook limitent cette plasticité. Cette limitation permet de faire apparaître une valeur marchande.

Prenons l'exemple d'achat de jouets à Noël. J'ai recherché sur Google des jouets pour un bébé de 8 mois. Je les ai commandé sur un portail de vente en ligne. Ensuite, sur Facebook, j'ai partagé la photos de ces jouets manipulés par le bébé avec mon entourage. Pendant le mois qui a suivi, mon écran a affiché sous forme de publicité ces jouets ou des jouets équivalents. Je suis devenu "acheteur de jouets de bébé". En fait, j'ai été vendu comme "cible" aux portails de vente en ligne de fournisseurs de produits pour enfants

La valeur d'usage des signes dans les réseaux sociaux est donc accompagnée d'une valeur marchande.

Actuellement, les réseaux sociaux permettent un nouveau type de commerce. Les membres de ces réseaux affichent leurs activités et leurs intérêts, et indiquent leurs préférences par rapport aux activités et intérêts de leurs proches. Des compagnies comme Google ou Facebook sont en mesure de segmenter ces activités et intérêts pour constituer des cibles de prospects. Ces cibles sont ensuite vendues aux annonceurs. La publicité est donc adressée de façon ciblée.

Nous proposons l'idée que ces deux valeurs développent des dynamiques contradictoires. Nous allons esquisser ici une tentative de modélisation mathématique en nous aidant de deux modélisations existantes : la Loi de Metcalfe et l'effet d'externalité.

Les concepts d'usage complet et d' "intégration des externalités"

Nous nous donnons en préalable un idéal type (au sens du sociologue Max Weber) : un club suffisamment constitué pour être capable de supporter des transactions économiques entre des fournisseurs/vendeurs et des acheteurs/usagers. Nous viserons un niveau de constitution qui soit une "société". C'est à dire que fournisseurs /vendeurs ou acheteurs / usagers, apparaissent comme ayant une même "société" caractérisée par une grande quantité de valeurs communes. Et réciproquement.

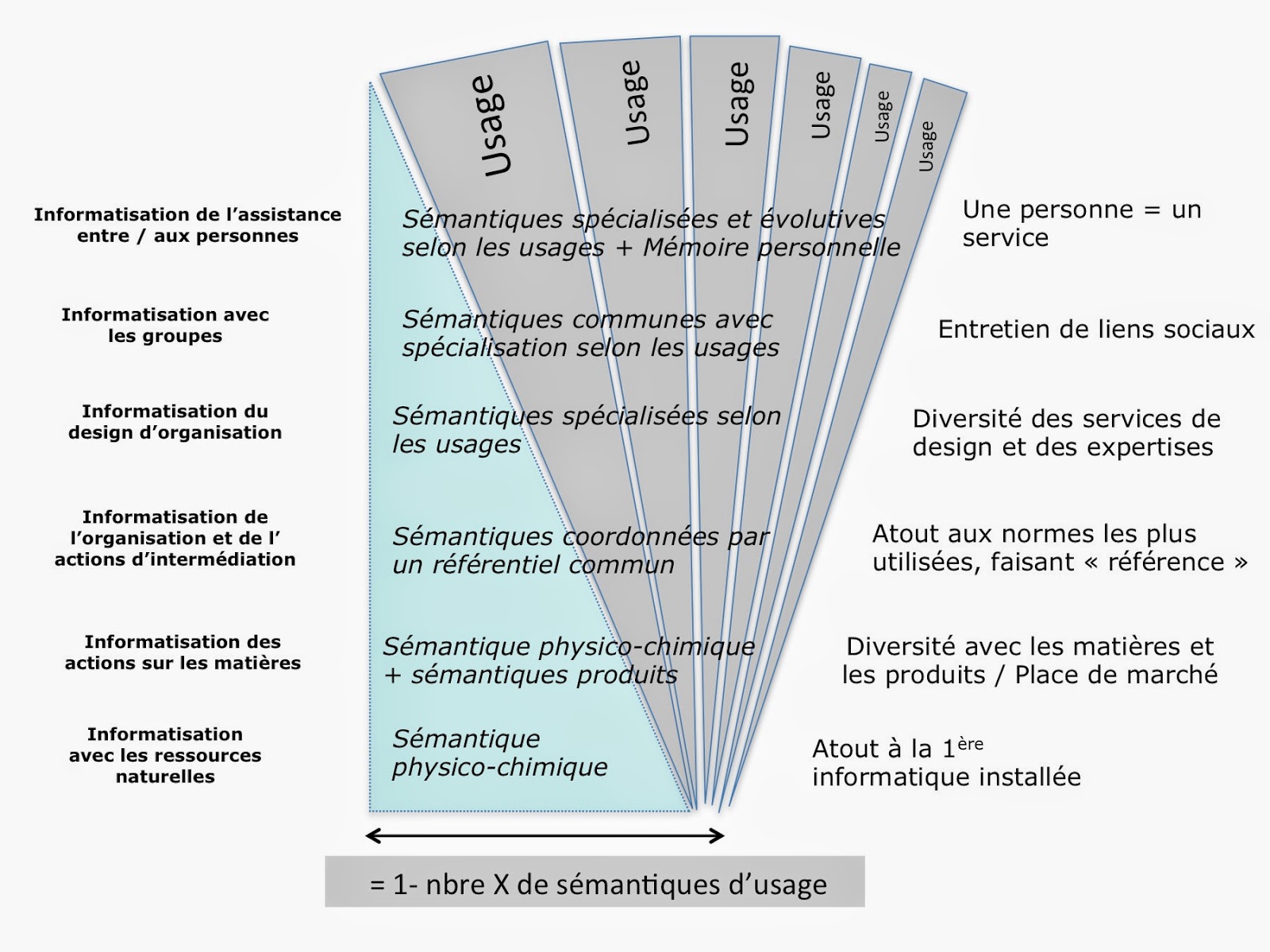

Donnons nous donc un idéal type, où une série d'externalités peut être composée et intégrée selon un "usage complet". Cette série d'externalités est considérée comme intégrée lorsque une société s'accorde sur les qualités d'usage de cet objet technique.

"L'externalité positive maximisée" serait le panorama de l'ensemble des externalités positives telles qu'elles s'articulent de façon à apparaitre à la fois distinctes entre elles et s'intégrant dans un même "usage complet".

La différence entre usage et identité

Chaque usage apparait assez constituée pour être qualifié par une "identité commune", au sens d'une "identité commune reconnue au sein d'une société". Par exemple, dans la société française, une appellation contrôlée "viticulture française bio" deviendrait un usage par la sommation de ses externalités positives.

Il y a d'un coté la bouteille de vin issue d'un processus technique en vu d'un usage ayant la complétude "bio". De l'autre, il y a l’appellation d'origine contrôlée, qui est une des identités de cette bouteille de vin.

Nous considérons l'identité comme un moteur du partage initial où se constitue une externalité. L’appellation "viticulture française bio" ne peut pas faire l'objet d'un calcul économique de type "recettes/coûts". Mais la société juge que cette appellation, qui est le résultats de plusieurs décennies d'effort, permet de plus grandes quantités de vente et un prix à la vente plus élevé.

Critique de la valeur marchande de la cible sur Internet

Constituer une "cible" pour la vendre à un annonceur permet de monétiser la valeur attribuée à l'usage d'Internet. En première approche, cette monétisation fait sortir la valeur d'usage des internautes rassemblés dans cette cible du champ de pertinence de la Loi de Metcalfe et de l'externalité Effet de club.

Cependant, il n'y a pas une cible, mais une série de cibles adressées par une multitudes de portails ou de sites de vente en ligne. L'effet produit par cette multitude peut s'analyser comme une externalité. Nous poserons que cette externalité est négative car la multiplication des cibles aboutit à un "Chaos" où les identités se brouillent ou s'avèrent factices.

Tout serait falsification car il suffirait d'un signe isolé pour fonder une identité. Par exemple, il aurait des appellations "viticulture française bio" pour des vins fabriqués en Australie selon des méthodes utilisant massivement des sulfites. En effet, un pied de vigne aurait été acheté dans un domaine faisant du bio France, puis revendu en Australie et cela suffirait pour étendre l'externalité "viticulture française bio".

La valeur marchande détruit la valeur d'usage.

Le pas intellectuel que nous proposons de faire est celui-ci : il faut considérer que les valeurs marchandes détruisent les valeurs d'usage des réseaux sociaux selon la loi de Metcalfe. La destruction des valeurs d'usage obéit à un effet d'externalité.

Est-il possible de calculer cette destruction, sachant que par définition, l'externalité se définit comme économiquement incalculable.

Dans notre tentative, nous considérerons qu'il existe un bien valorisé : "l'Identité d'usage complet". Il existerait par ailleurs un coût lié à la réduction du phénomène "divergence identitaire" et de ses éléments "divergeant identitaires".

Un processus économique en six temps

Donc, l'Identité d'usage peut être caractérisée par un processus en 6 temps :

- un temps 1 où tous les coûts des matériaux d'un produit peuvent être additionnés en un coût global, coût global qui peut être comparé un prix de vente, aboutissant au calcul d'un bénéfice

- un temps 2 où la diffusion de l'usage complet amène la formation d'un effet d'externalité positive, aboutissant à une identité forte = Identité d'usage

- un temps 3 où des variétés d'usages se développent

- un temps 4 ou ces variétés d'usage se transforme en plusieurs Identités d'usage concurrentes

- un temps 5 où la diversité des Identités se transforment en externalité négative du point de vue de l' Identité d'usage originelle.

- un temps 6 où l'externalité négative induit des dépenses de reconstruction de l'externalité positive.

La lutte contre l'externalité 'négative' va avoir comme effet de sélectionner un petit nombre d'Identités d'usage 'faible' et de les construire. Cette sélection se fait par des dépenses chiffrables en innovation, design, communication, circuit de distribution. Il y a donc un lien qui apparait entre l'économie classique de type coûts/recettes/bénéfices et l'économie des externalités.

Jusqu’où il est économiquement rationnel de financer des dépenses de construction d' une externalité positive par rapport à un usage existant ? Jusqu'où un usager est prêt à payer pour co-construire une identité d'usage ?

UN MODÈLE ECONOMIQUE DE "MAINTIEN DE L'IDENTITE DE L'USAGE COMPLET"

Utilisons un modèle simple de "Divergence identitaire" typique du Web. Des sites, en nombre K, sont installées dans le Web et se présentent comme l'indice de nouvelles " identités d'usage". Ils diminuent l'effet l'externalité positive d'une "Identité usage originelle". Ces sites seront qualifiés de "Divergent"

- y désigne le grandeur de l'effet de l'externalité positive,

-

La quantité de diversité identitaire créée par les divergents j est notée

La grandeur de l'effet de l'externalité positive y dépend de la soustraction de la quantité totale de nouvelles identités divergentes

Sans aucune intervention régulatrice, les sites ne sont pas incités à réduire leur diversion identitaire, car leur objectif est de maintenir un y faible. Dans ce cas les sites produisent chacun une quantité de diversants identitaires égale à

Pour les usagers du Web, la qualité de l'externalité positive de "l'usage originel complet" est un bien commun sociétal. Le consentement à payer de l'usager i (fournisseur ou acheteur) pour passer d’un usage de qualité initiale

Considérons maintenant des technologies de traitement des divergents identitaires avec des évolutions de l'usage et des ajustements de l' externalité.

Pour le divergeant j le coût pour passer d’une quantité de divergents identitaires

Du point de vue de l’efficacité collective il y a un double arbitrage à réaliser :

- l’arbitrage en faveur du coût initialement élevé de l'évolution, ce qui a l’avantage de restaurer rapidement l'identité de l'usage originel complet, et donc des coûts marginaux décroissants

- l'arbitrage en faveur de la répartition de la charge d'ajustement des identités entre les différents sites K d’autre part ; c'est à dire faire se rapprocher le montant des coûts marginaux supportés par les différents partenaires.

De ces deux arbitrages résultent la création ou non de concurrents et la structuration des réseaux de partenaires.

L'intérêt économique d'avoir des concurrents

Une entreprise idéale prendrait en compte l'ensemble des identités d'usage. Cependant, le coût d'évolution de l'usage complet serait très élevé, et la décroissance du coût marginal faible au départ. A ceci s'ajoute que l'évolution de l'usage complet ne peut pas techniquement adresser l'ensemble des perturbations identitaires. Donc, une entreprise fera le choix de traiter certains perturbants identitaires, et de laisser les autres à ses concurrents.

Il est clair d’abord que le coût total de fabrication des nouvelles identités (liées à l'évolution de l'usage complet), pour une quantité donnée de perturbants identitaires, doit être minimisé. Ceci impose donc que, pour chaque niveau total donné de perturbants identitaires q envisagé, les quantités de perturbants identitaires qui affectent les différents usagers soient :

C’est à dire telle que la répartition des perturbants identitaires pris en compte minimise le coût total.

Il en résulte qu’on doit répartir la charge de fabrication des nouvelles identités de manière à égaliser les coûts marginaux d'évolution :

Si ce n’était pas le cas il est possible, pour une quantité totale donnée de perturbants identitaires, de diminuer le coût total en autorisant une augmentation des perturbants identitaires d'usager entraînant un coût marginal élevé. Autrement dit, une option stratégique est de permettre la mise en place d'un concurrent qui adresse ces perturbants identitaires, concurrent qui prendrait à sa charge des coûts marginaux élevés.

Cela serait compensé, pour l'entreprise qui fait ce choix, par une diminution des perturbants identitaires et par leur traitement avec un coût marginal faible.

Lorsque les concurrents possibles désertent

Concrètement, dans le Web, faute d'une régulation économique globale, les usagers initiateurs ayant des images identitaires fortes renforcent leurs identités numériques, tandis que les nouveaux entrants porteur de perturbants identitaires ne font pas d'effort pour réduire leur perturbation.

Les nouveaux entrants préfèrent laisser en place les pollutions identitaires car ils n'ont pas la capacité financière d'adresser des coût élevés d'évolution, pour aboutir à un nouvel usage complet qui ferait vraiment concurrence à l'usage initial.

Nous en avons un exemple dans la relation entre Majors des médias et sites peer-to-peer. Les sites peer-to-peer ont mis au point des procédés techniques et instauré des usages que les majors des médias ne cherchent pas à concurrencer.

Le site http://valentin-guerin.fr/ après enquête note

"Ne me demandez pas pourquoi, mais si le téléchargement illégal a toujours autant la cote, c’est tout simplement parce que l’offre légal n’existe presque pas ; 80% des 10 films les plus téléchargés dans le monde ne sont pas disponibles légalement en France."

Vers l'optimisation de l'incitation à adresser une perturbation identitaire

Imaginons que les Etats aient une intervention régulatrice qui poussent les nouveaux entrants à contribuer à l'effet de club, donc à prendre en compte les coûts d'évolution de maintien de l'externalité positive, c'est à dire l'évolution de l'usage complet et de ses identités.

L'enjeu est de persuader un nouvel entrant à engager une dépense correspondant à un coût marginal relativement élevé. De combien le coût marginal est élevé par rapport au coût marginal moyen ?

Si l’on note :

le coût total de l'évolution de l'usage complet, on obtient par le théorème de l’enveloppe :

Le coût marginal total de fabrication d'identité (que l’on notera  ) est égal, à l’optimum, au coût marginal commun dépensé par chacun des usagers.

) est égal, à l’optimum, au coût marginal commun dépensé par chacun des usagers.

Il s’agit ensuite de déterminer la quantité efficace de perturbants identitaires à adresser. L’équation nous donne alors la solution : la quantité efficace de perturbants identitaires

LES INSTRUMENTS DE LA RÉGULATION

Dans le paragraphe suivant, il faut considérer les notions de "taxe", de "subvention" et de fiscalité comme des moyens d'action d'une puissance régulatrice du web. On imaginer que le terme "taxe" représente un encadrement juridique de l'action des usagers par des droits à respecter.

A l'inverse, la "subvention" serait des encouragements à des évolutions apportant un haut niveau de service aux usagers, services de qualité qui permettraient aux fournisseurs de facturer un prix conséquent.

Etant donné le cout d'effort de coopération à construire une identité forte, il n’y a aucune incitation, pour les usagers, à entreprendre une réduction de leur émission de perturbants identitaires ? Quels instruments sont susceptibles de les responsabiliser?

La première idée serait d’appliquer le principe “ pollueur-payeur ” en "taxant" les sites en fonction de la quantité de perturbants identitaires dispersés. C’est là, en quelque sorte, un instrument d’intéressement “ négatif ” : la perturbation identitaire est sanctionnée.

La seconde solution consisterait à "subventionner" la fabrication d'identité lors de l'évolution de l'usage complet. C’est plutôt là un instrument d’intéressement “ positif ” : la fabrication d'identité est récompensée.

Ces différentes solutions correspondent comme on le verra un peu plus loin à une répartition implicite des droits de propriété sur le “Bien Commun” environnement/ Web.

Examinons plus généralement l’incidence d’un instrument mixte comprenant, une "taxe" linéaire à la perturbation d'identité

Face à un tel instrument, l'usager j choisit un niveau de perturbants identitaires qui minimise le coût restant à sa charge :

c’est à dire vérifiant :

Comment faire alors pour que la décision de l'usager soit efficace? Un simple coût d’oeil suffit pour remarquer qu’en fixant les paramètres "fiscaux" de manière à avoir

Il faut remarquer cependant que la fixation du schéma "fiscal/régulateur" optimal est fortement conditionné par l’information dont dispose la puissance régulatrice : il faut, d’après les équations précédentes, que la puissance régulatrice soit en mesure de calculer

Par ailleurs, "taxe" et "subvention" apparaissent comme des instruments substituts au sens où un niveau élevé de la "taxe" implique un niveau faible de la subvention. Pour

De manière schématique on voit que le dosage entre les différents paramètres "fiscaux" induit une répartition différente du surplus dégagé par rapport à la situation initiale : la "taxation" se fait au détriment des usagers, la "subvention" à leur profit.

Externalité et droits de propriété

Une autre façon d’interpréter cet effet redistributif consiste à considérer la situation initiale (dispersion/perturbation identitaire maximale) comme une configuration dans laquelle les droits de propriété sur un Bien commun, les "Identités de l'usage complet", font défaut.

Si l’on spécifie, par exemple, que les "Identités de l'usage complet" “appartiennent” de plein droit aux initiateurs, alors ceux-ci sont en mesure de “monnayer” l’usage comme réceptacle à perturbants identitaires. La "taxe" s’interprète ici comme le prix de cet usage.

Au contraire, si l’on spécifie que l'évolution de l'usage “appartient” au nouveaux entrants, ceux ci sont en mesure de “vendre” la qualité de l'évolution de l'usage, et c’est la "subvention" qui joue ce rôle.

Certains affirment que "le problème de l' externalité" est en fait causé par l’absence de droits de propriété clairement définis sur certains biens. Si le comportement d’un agent influence le bien-être d’un autre sans qu’il y ait transaction, c’est que la victime ne peut pas institutionnellement faire valoir un droit à “ ne pas être gêné ” ce qui peut dans de nombreux cas se traduire par un droit sur la propriété du “ vecteur ” de l’externalité : l’air, l’eau, le paysage, le panorama des identités...

Reprenons l’exemple des usagers au sein du web. Supposons que les usagers sont représentés par la puissance régulatrice et généralisons l’idée de droit de propriété sur "l’environnement/Web" de la façon suivante. La ressource identitaire est caractérisée, ex ante, avant toute intervention, par un panorama, au sein de l'usage complet, des distinctions d'identité de qualité

Partager le droit de propriété sur les identités de l’usage complet revient à répartir

Il en résulte alors en procédant de même pour tous les nouveaux sites, que la part qui revient à l'usager/club de service spécifique est

Pourquoi les riches sont de plus en plus riches

Pouvons nous rendre compte d'un effet de l'économie actuelle qui fait que les riches sont de plus en plus riches et les pauvres de plus en plus pauvres ? Reformulons le mécanisme ainsi : lorsqu'il y a des coûts de transformation d'une ressource, entre deux transformations, c'est la moins coûteuse qui est choisie. Le coût est évalué non pas dans l'absolu, mais en proportion d'un capital de départ.

Autrement dit, lorsque un "riche", avec un capital de 10 000 000 € investit dans une transformation qui coûte 10 000 € , le rapport est de 1/1000. La décision d'investir ne pose pas de difficulté.

Lorsqu'un "pauvre" ne dispose que de 10 000 €, le rapport est de 1. La décision d'investir est difficile à prendre.

Maintenant, considérons Internet : il y a énormément de ressources "perturbées" qu'il faut transformer avant de les insérer dans un process productif rentable. Cela dissuade les "pauvres".

C'est pourquoi, il parait important de modéliser les couts générés par les "perturbation d'identités".

En conclusion

La nouvelle économie Web consiste à arbitrer en faveur de clubs, de communautés ouvertes facilitant des échanges économiques valorisant les effets d' externalité positive, et réduisant les effets d' externalité négative.

ANNEXES

La Loi de Metcalfe

La dynamique de valeur d'usage d'un réseau pour un individu peut être mesurée par la Loi de Metcalfe : "L’utilité d’un réseau est proportionnelle au carré du nombre de ses utilisateurs".

La Loi de Metcalfe est une loi théorique et empirique énoncée par Robert Metcalfe (fondateur de la société 3Com et à l'origine du protocole Ethernet).

La loi de Metcalfe mesure les effets de réseau liées aux technologies de l'information, applicable à des réseaux comme Internet, les systèmes de réseautage social et le World Wide Web. Elle calcule que le nombre de liens potentiels dans un réseau avec  nœuds est

nœuds est  , fonction équivalente à

, fonction équivalente à  pour

pour  tendant vers l'infini.

tendant vers l'infini.

Autrement dit, simplement que plus il y a d'utilisateurs dans un réseau, plus ce réseau aura de la valeur.

- Elle trouve à s'appliquer dans n'importe quel réseau social (de type Facebook par exemple). Si vous vous trouvez seul inscrit vous n'y trouvez aucune utilité mais si toutes vos connaissances font également partie du réseau alors les fonctions de partage et d'échange commencent à prendre du sens.

- Elle explique aussi que le contenu d'outils collaboratifs (Wikipédia par exemple) s'enrichit et devient plus efficace, de manière encore plus rapide que la vitesse de croissance du nombre des contributeurs.

- Elle est en rapport avec la 3eme colonne du Triangle de Pascal 1, 3, 6, 10, 15, 21, …, soit 1 pour 2 noeuds, 10 pour 5 noeuds, et 66 pour 12 noeuds.

L'effet d'externalité

Voici la définition de l'externalité selon Dominique Henriet

" On dit qu’il y a externalité lorsque l’activité de consommation ou de production d’un agent a une influence sur le bien-être d’un autre sans que cette interaction ne fasse l’objet d’une transaction économique."

Avec cette définition, nous pouvons qualifier la Loi de Metcalfe comme "mesure d'une externalité".

On distingue les externalités positives et les externalités négatives. On parle d’externalité positive dans le cas où l’interaction aboutit à une augmentation de bien-être. L’effet de norme ou de club est l’exemple d’externalité positive réciproque : la valeur accordée par un consommateur à un produit ou à un service augmente lorque le nombre de consommateurs de ce produit ou service s’accroît.

Considérons le téléphone ou la télécopie: plus le réseau est étendu, plus nombreux sont les correspondants accessibles et donc plus le raccordement devient intéressant pour un nouvel abonné.

La pollution est l’exemple le plus typique d’externalité négative : lorsqu’une usine pollue son environnement en rejetant des déchets, elle inflige une nuisance aux habitants de la région. Cette pollution n’est pas nécessairement attachée à des rejets toxiques, elle peut être visuelle (la construction d’un équipement productif ou même de logements peut altérer la vue initiale des riverains), sonore, ou de manière plus générale, modifier certains équilibres naturels ce qui, indirectement, peut affecter le bien-être de certains agents de l’économie.

L’encombrement dû à la circulation automobile est un autre exemple d’externalité négative réciproque : chaque automobiliste gêne son voisin de sorte que l’augmentation de la circulation entraîne une congestion qui rend les déplacements de plus en plus difficile.

La définition d’une externalité est de ne pas être associée directement à une transaction économique. Il en résulte que l’arbitrage présidant à la décision économique ne tient pas compte des coûts ou des avantages associés à l’externalité. Ceci ne veut pas dire qu'il n' y a aucune incidence économique. Dans le cas de l’externalité positive, cela conduit à une tendance à une diminution des coûts et une augmentation des bénéfices. Mais cette tendance ne peut se démontrer par un calcul.

Dans le cas de la téléphonie mobile, le coût commercial de recrutement des abonnés baisse, puisque les abonnés s'incitent les uns des autres à entrer dans le club. Au démarrage de la téléphonie mobile, le service d'envoi de SMS valorisé par son externalité positive a été vendu à un prix reflétant plus l'intérêt du client que la réalité des coûts .

Dans le cas d’une externalité négative cette omission aboutit à une tendance à une augmentation des coûts et à une perte de bénéfices.

Considérer le partage des signes sous l'angle de ses externalités, c'est le replacer dans un environnement global, et l'envisager selon ses usages et les effets de ces usages.